Evaluation Method and Confusion Matrix (วิธีการประเมินและเมตริกซ์ความสับสน) เป็นเครื่องมือที่ใช้ในการวัดและประเมินประสิทธิภาพของโมเดลทำนายในงานการเรียนรู้และการจำแนกข้อมูล โดยเฉพาะในกรณีที่มีปัญหาการจำแนก (Classification Problems) ซึ่งต้องการทำนายประเภทหรือคลาสของข้อมูล มีวิธีการต่าง ๆ ในการประเมินความแม่นยำและประสิทธิภาพของโมเดลดังนี้:

- Accuracy (ความแม่นยำ): คืออัตราส่วนของข้อมูลที่ทำนายถูกต้องต่อจำนวนข้อมูลทั้งหมดในชุดข้อมูลทดสอบ (Testing Data)

- Precision (ความแม่นยำในการพยากรณ์ค่าบวก): คืออัตราส่วนของจำนวนข้อมูลที่ทำนายถูกต้องเป็นค่าบวก (Positive Class) ต่อจำนวนข้อมูลที่ทำนายว่าเป็นค่าบวก

- Recall (ความแม่นยำในการคืบหน้าค่าบวก): คืออัตราส่วนของจำนวนข้อมูลที่ทำนายถูกต้องเป็นค่าบวก (Positive Class) ต่อจำนวนข้อมูลที่เป็นค่าบวกในชุดข้อมูล

- F1 Score: เป็นค่าเฉลี่ยฮาร์มอนิกซ์ของ Precision และ Recall เพื่อให้ควบคุมความสมดุลระหว่างความแม่นยำในการพยากรณ์ค่าบวกและความแม่นยำในการคืบหน้าค่าบวก

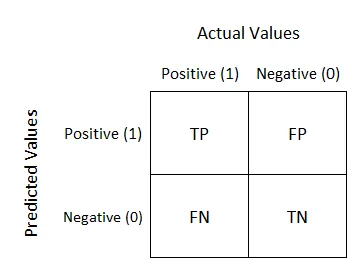

Confusion Matrix (เมตริกซ์ความสับสน) เป็นตารางที่ใช้ในการแสดงผลลัพธ์ของการทำนายโดยแบ่งข้อมูลที่ทำนายได้เป็น 4 ส่วน ดังนี้:

- True Positive (TP): จำนวนข้อมูลที่ถูกต้องที่มีการทำนายว่าเป็นคลาสบวก (Positive Class) หรือค่าบวกและค่าจริงของข้อมูลเป็นคลาสบวกเช่นกัน

- False Positive (FP): จำนวนข้อมูลที่ไม่ถูกต้องที่มีการทำนายว่าเป็นคลาสบวก หรือค่าบวกแต่ค่าจริงของข้อมูลเป็นคลาสลบวก (Negative Class)

- True Negative (TN): จำนวนข้อมูลที่ถูกต้องที่มีการทำนายว่าเป็นคลาสลบวก หรือค่าลบและค่าจริงของข้อมูลเป็นคลาสลบวก

- False Negative (FN): จำนวนข้อมูลที่ไม่ถูกต้องที่มีการทำนายว่าเป็นคลาสลบวก หรือค่าลบแต่ค่าจริงของข้อมูลเป็นคลาสบวก

รูปภ่าพมาจาก https://towardsdatascience.com/understanding-confusion-matrix-a9ad42dcfd62

Confusion Matrix ใช้ในการวัดประสิทธิภาพของโมเดลทำนายและการจำแนกข้อมูลในแต่ละคลาส โดยเราสามารถคำนวณหาค่าความแม่นยำ (Accuracy), ความแม่นยำในการพยากรณ์ค่าบวก (Precision), ความแม่นยำในการคืบหน้าค่าบวก (Recall), F1 Score และค่าอื่นๆ ที่เกี่ยวข้องได้จาก Confusion Matrix ดังนี้:

- Accuracy (ความแม่นยำ): คืออัตราส่วนของข้อมูลที่ทำนายถูกต้องต่อจำนวนข้อมูลทั้งหมดในชุดข้อมูลทดสอบ (Testing Data) Accuracy = (TP + TN) / (TP + TN + FP + FN)

- Precision (ความแม่นยำในการพยากรณ์ค่าบวก): คืออัตราส่วนของจำนวนข้อมูลที่ทำนายถูกต้องเป็นค่าบวก (Positive Class) ต่อจำนวนข้อมูลที่ทำนายว่าเป็นค่าบวก Precision = TP / (TP + FP)

- Recall (ความแม่นยำในการคืบหน้าค่าบวก): คืออัตราส่วนของจำนวนข้อมูลที่ทำนายถูกต้องเป็นค่าบวก (Positive Class) ต่อจำนวนข้อมูลที่เป็นค่าบวกในชุดข้อมูล Recall = TP / (TP + FN)

- F1 Score: เป็นค่าเฉลี่ยฮาร์มอนิกซ์ของ Precision และ Recall เพื่อให้ควบคุมความสมดุลระหว่างความแม่นยำในการพยากรณ์ค่าบวกและความแม่นยำในการคืบหน้าค่าบวก F1 Score = 2 * (Precision * Recall) / (Precision + Recall)

Confusion Matrix ช่วยให้เราสามารถทราบถึงการแยกแยะระหว่างคลาสในการทำนายของโมเดล โดยจะแสดงข้อมูลที่ทำนายถูกและไม่ถูกต้องในแต่ละคลาส ทำให้สามารถวิเคราะห์ประสิทธิภาพของโมเดลได้ด้วยความแม่นยำและประสิทธิภาพในการทำนายในแต่ละคลาส